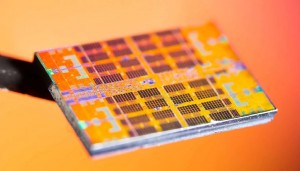

ChatGPT’nin önyargıları ortaya çıktı

ChatGPT, son araştırmalara göre insan gibi karar alma hataları yapıyor. Aşırı güven gibi önyargılar sergiliyor. Matematikte başarılı olsa da yargı gerektiren kararlarda zorlanıyor, bu da yapay zekanın güvenilirliğini sorgulatıyor.

Yapay zekanın insanlardan daha güvenilir kararlar alacağı düşüncesi, yeni bir araştırmayla sarsıldı. OpenAI’nin geliştirdiği ChatGPT, en ileri yapay zeka modellerinden biri olmasına rağmen insanların sıkça düştüğü karar alma hatalarını tekrarlıyor.

INFORMS dergisi Manufacturing & Service Operations Management’ta yayımlanan çalışma, yapay zekanın sandığımızdan daha çok bize benzediğini gözler önüne seriyor.

İnsanlara benzeyen yanılgılar sergiliyor

Araştırmacılar, ChatGPT’yi 18 farklı önyargı testine tabi tuttu ve sonuçlar oldukça çarpıcı.. Model, testlerin yaklaşık yarısında aşırı güven, kumarbaz yanılgısı ve belirsizlikten kaçınma gibi insanlara özgü bilişsel tuzaklara düştü. Matematik ve mantık problemlerinde kusursuz bir performans sergileyen yapay zeka, öznel yargı gerektiren kararlarda ise tökezledi.

Örneğin, riskli ama potansiyel olarak daha kazançlı seçenekler yerine temkinli davranmayı tercih etti ve kendi doğruluğunu abarttı. Yeni nesil GPT-4 modeli, analitik açıdan daha iyi olsa da yargı temelli görevlerde önyargıları bazen daha belirgin hale geldi.

Uzmanlar, yapay zekanın insan verilerinden öğrenirken bu önyargıları da miras aldığını belirtiyor. Western Üniversitesi’nden Yang Chen, “Yapay zeka, zihinsel kestirmelerle insan gibi düşünüyor,” derken, Queen’s Üniversitesi’nden Anton Ovchinnikov, “Net cevaplı sorularda başarılı, ama yargıda insan gibi yanılıyor,” diye ekliyor. İş dünyasında işe alımdan kredi onayına kadar kritik kararlar alan yapay zekanın bu kusurları, güvenilirlik tartışmalarını öne çıkarıyor.

Yapay zeka için de etik kurallar mı gerekiyor?

Araştırma, yapay zekanın tarafsız bir karar mercii olmaktan uzak olduğunu ve insan önyargılarını pekiştirme riski taşıdığını ortaya koyuyor. Uzmanlar, yapay zekanın bir çalışan gibi denetlenmesi ve etik kurallarla yönlendirilmesi gerektiğini savunuyor.

McMaster Üniversitesi’nden Meena Andiappan, “Hatalı düşünceyi otomatikleştirmek yerine iyileştirmeliyiz” diyor. Yapay zekanın etkisi arttıkça, düzenli denetim ve model geliştirme, onun insan kusurlarını kopyalamak yerine gerçekten faydalı bir araç haline gelmesi için şart görünüyor. Bu bulgular, yapay zeka düzenlemeleri üzerinde çalışan hükümetler ve işletmeler için de bir uyarı niteliği taşıyor.

Sonuç olarak, ChatGPT, insan gibi karar alma hataları yapıyor ve önyargılarıyla şaşırtıyor. Matematikte başarılı, yargıda zayıf kalan yapay zeka, insan düşüncesini yansıtıyor. Uzmanlar, iş ve kamu yönetiminde kullanılan yapay zekanın denetlenmesi gerektiğini vurguluyor.

|

Yorumcuların dikkatine… • İmlası çok bozuk, • Büyük harfle yazılan, • Habere değil yorumculara yönelik, • Diğer kişilere hakaret niteliği taşıyan, • Argo, küfür ve ırkçı ifadeler içeren, • Bir iki kelimelik, konuyu zenginleştirmeyen, yorumlar KESİNLİKLE YAYIMLANMAYACAKTIR. |

Bu haber henüz yorumlanmamış...

Bunlar da ilginizi çekebilir...